A/B测试增长实战( 四 )

这时他犯了难,如果开ab实验呢就需要一周,耽误事,而且用户量也不大,能回收的数据也不多影响实验效果靠人经验拍决策质量最不稳定,因此我们就推荐他智能化实验完美地解决了这个问题。

实验开启后无需操作和关注数据,abcd四组文案在每一次下发后都会实时收集反馈,自动根据上一轮的结果决定下一轮发什么,效果好的就加大流量效果差的就干掉,中规中矩的就给一少量流量留用观察,轮过几轮的循环推送,最终从均分,变成了绝大多数流量分给B和D脱颖而出并且旗鼓相当,A文案惨遭淘汰。最终效果相比均分,ctr提升9.2%,一定程度上实现了千人千面。

一旦实验增多,人力无法协调,智能动态调优实验就是一个解放人力的好方案。

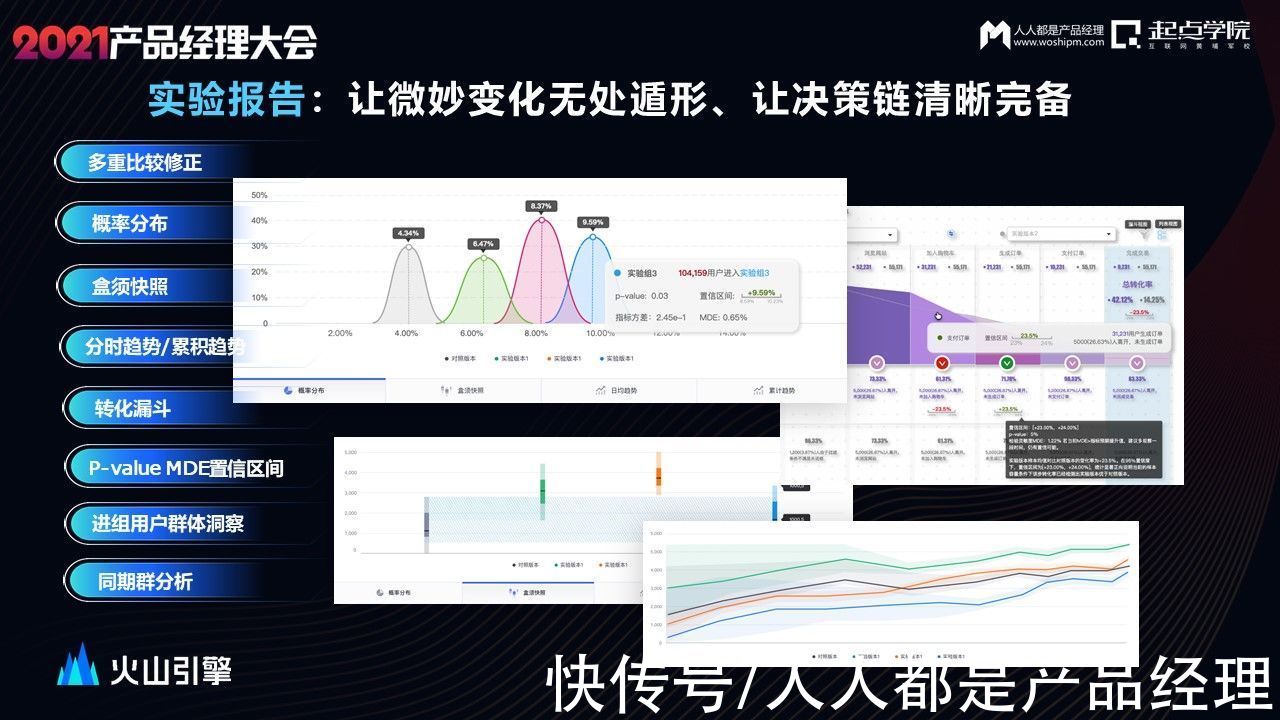

实验上线后,如何解读实验结果呢?目前结果如何,谁好谁坏好多少,哪一天出结果?

文章插图

例如,今天广州市的用户,在不同版本之间的转化率表现是怎么样的,方便我们更快速决策,知道我实验整体的结果和ROI,让我们的决策链更清晰完整。

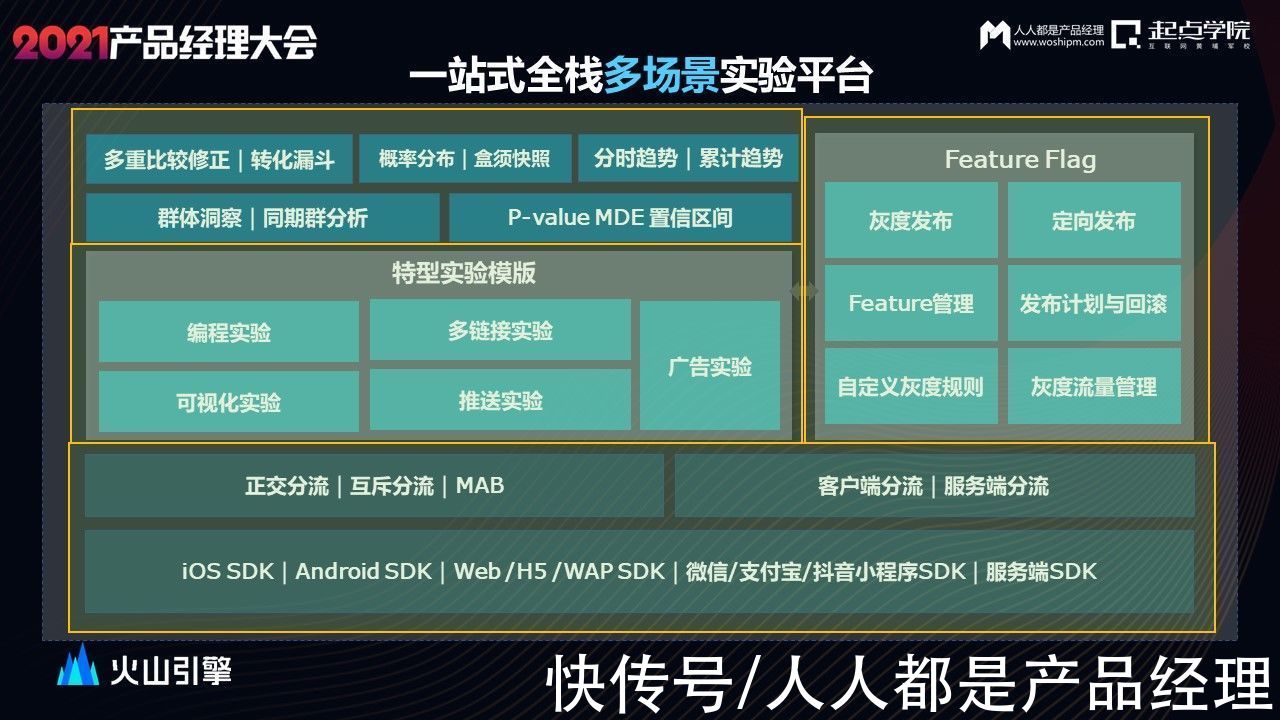

实现以上实验想法的一站式全栈多场景实验平台,他具有哪些能力呢?

文章插图

线上有多端的触点,多端sdk用来上报用户行为数据,根据实验的需要也可以从客户端或服务端实现分流,用以满足不同场景做实验的需求。

同时还需要有正交和互斥分流来保证分流的科学性。

说完分流,在不同的场景做实验,想要快速上线。编程实验、可视化实验、多链接实验、推送实验等都是能帮助产品和运营减少成本,快速上线实验的场景实验模板。

接着实验上线后,科学易懂的实验报告帮助解读实验数据,为业务做决策参考。

但是,A/B测试只是一个小流量的测试,产品推广到全量用户很有可能会产生性能崩溃、产品功能bug等问题。

Feature Flag智能发布可以帮助从小流量A/B测试验证成功的结果,丝滑稳定地过渡到全量用户中,为我们的产品迭代保驾护航。

综上,A/B测试有这些核心价值:

- 业务创新:通过持续的功能优化打磨,累积创新效果,逐步形成迄今最优的产品形态。

- 降本增效:降低试错成本,降低技术资源投入。例如UI交互优化,可直接通过可视化实验,无需申请研发资源,快速上线。

- 收益提升:优化产品购买流程/文案可直接带来可观的经济收益。

- 管理提效:业务部门精准衡量新策略/功能,对大盘整体的业绩贡献度,为管理层向上汇报提供准确的数据依据和科学度量。

文章插图

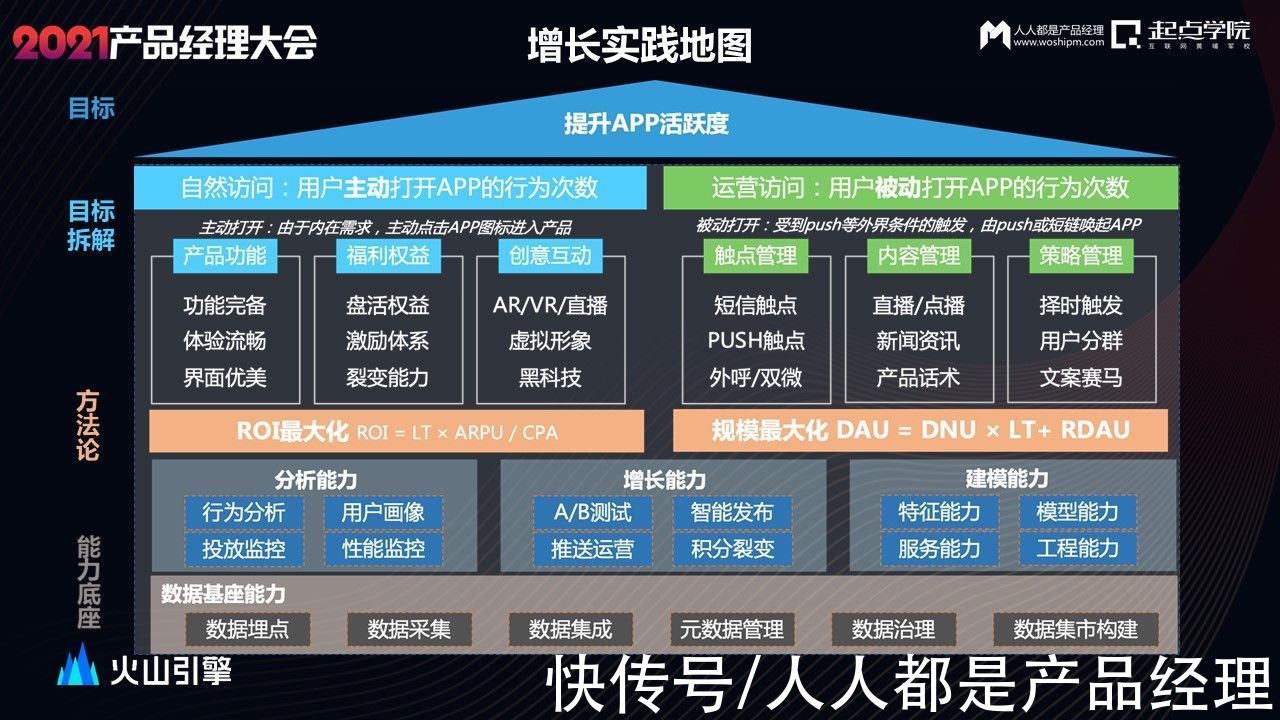

我们总结了一个增长实践的地图。

文章插图

火山引擎在产品运营方面是如何实现增长的呢?

从顶层目标【提升app活跃】进行拆解,得到提升主动自然访问和被动运营访问两个路径,自然访问通过完善产品功能体验,加强福利权益,创意互动等去支撑自然访问的提升,运营访就涉及精细化触达,通过触点,内容和策略的管理来实现提升被动打开的次数。

再通过不同的策略以及方法论,实现roi和规模的最大化,

这些其实都离不开强大的数据基座能力、数据分析,增长策略(包含ab测试),以及建模能力。

从下至上,达到提升活跃的最终目的。

我们的初心和愿景均是鼓励大胆创新,通过严谨的逻辑和工具小心求证,方能收获增长。

相关阅读《高代码产品经理时代:如何避免技术型产品的浪潮中被时代淘汰》

- 测试|解码自动驾驶商业化进阶的亦庄样本

- CPU|性价比不二之选!i5-12400网游测试:已看见锐龙7 5800X尾灯

- AMD 3D V-Cache 技术测试:延迟略增,但处理器性能更强

- 分发量|YY直播:2021年合作公会总数增长24%,百度导入流量3亿/天

- 太空旅客|华为视频App新版本测试:支持边下边播

- 36氪|启中教育:如何实现店铺爆发式增长

- 社区矫正中心|邯山区司法局推进“智慧社区矫正中心”建设,打造实战平台,提升矫正

- 年终篇:兴趣电商与国货增长的两大价值体系

- 腾讯云|实现TO B销售规模化持续增长三步法 | 腾讯云原生加速器

- 微信|微信发布 8.0.18 测试版,加入信息清单功能