文章图片

文章图片

文章图片

文章图片

作者| 宇多田

出品| 虎嗅科技组

封面来自the Verge

Facebook改名Meta后 , “财务厄运”并未因此终止 , 但技术作风却一如既往的大胆 。

虽然自2022年2月以来 , 公司股价已下跌30%, 市值损失超过2500亿美元 。 但是 , 这并没有影响开发者们的精神世界与工作动力 。

本周 , 来自Meta一小撮程序员的疯狂举动 , 在全球AI开发者群体中引发了巨大骚动——

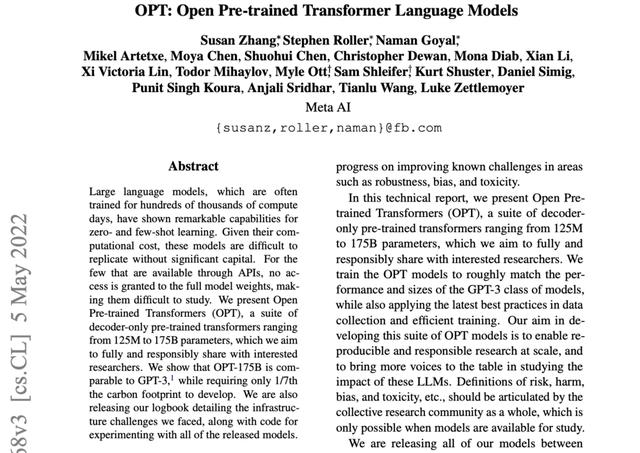

Meta AI 实验室高调宣布 , 将开放自己的语言大模型 OPT(Open Pretrained Transformer , 预训练变换模型) , 毫无保留地贡献出所有代码 。

不夸张地说 , 在人工智能圈 , 这算得上是一个里程碑事件 。

这个被称为OPT的大规模语言模型 , 自建立以来 , 各项参数与能力便精准对标OpenAI 的GPT3 , 甚至连缺点都是 。 后者在全球学术界建立的赫赫声望和随处可见的网络小说续写作品 , 想必已不必再过多赘述 。

简而言之 , 这是一种利用巨量网络文本与书籍进行训练 , 可以将单词和短语串在一起组成精彩文本的深度学习算法模型 。

它能生成复杂句子 , 有时候甚至读起来与人类撰写毫无无异(想粗浅了解GPT , 可以看这篇《让00后疯狂的超级算法》) 。 某种程度上 , 它所具备的神奇人工文本模仿能力 , 被视为人类通往真正机器智能道路上的一个巨大突破口 。

GPT3生成的文本

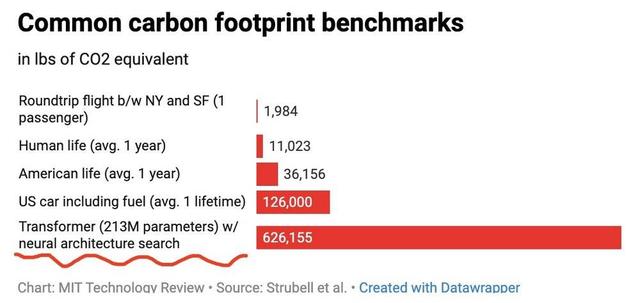

然而 , “培育”大模型的代价 , 是昂贵的人力成本与成千上万块显卡 。 因此 , 许多学者都认为 , 把这种大模型开放出来 , 几乎不可能发生在“游走在垄断边缘”的大型科技公司身上 。

譬如 , OpenAI 的GPT3曾被专家粗略估算过 , 至少投入了1000万美元 。 他们后来为了摆脱入不敷出的现状 , 将GPT3作为一项付费服务来推广——只提供API , 但不会开放模型本身和底层代码 。

然而 , Meta表示 , 会把不同参数规模的训练模型以及“OPT如何建造和训练”的详细信息分发给研究人员 。

其中 , 也包括一份超过100页的算法训练日志——实验室记录下的每一个错误与崩溃现象 , 训练和添加数据的过程 , 以及有效与无效策略 。

“考虑到计算成本 , 如果没有大量资金 , 这些模型很难复制 。 对于少数通过api可调用的模型(这里暗指GPT3) , 如果不能获得完整的模型权重 , 就难以进行研究 。 ”他们在OPT的论文摘要里鲜明表达了态度 ,

“因此 , 我们推出了OPT(这是一个只有解码器的预训练变换模型) , 参数范围从125M到175B , 目标是全面且负责任地分享给感兴趣的研究人员 。 ”

“是真的开放 。 ”

一位“正准备去看看他们实现情况”的中国开发者查阅了MetaAI网站后 , 告诉虎嗅 , 这的确是一个好消息 。 “从现有数据来看 , 整个训练代码都被贴出来了 。 Meta很了不起 。 ”

擅用集体力量

这一次开源 , 毫无意外受到了学术界的高度认可 , 甚至有科学家称其是一个伟大的举动 。

究其原因 , 一方面 , 一项强大技术 , 如何在一个封闭的企业精英团队中诞生 , 一直是包括学界在内大众好奇的焦点;

- iPad|首次升级自研M1芯片!iPad Air 5蜂窝版开售:5499元起

- 盘点微软 10 大开源项目:Visual Studio Code 最受欢迎

- |ARM还是“成功”了!拿下安谋中国后,开源架构需要尽快突破!

- 京东方|我国反超韩国,17年来首次成世界第一!拿下全球41.5%显示屏份额

- 华为|押宝骁龙7 Gen1能不能成?OPPO Reno8跑分首次曝光

- 量子|“墨子号”首次实现1200公里地表量子态传输

- UntamedMetaverse|开发保护大自然主题元宇宙游戏,Untamed Planet完成2430万美元融资

- meta|大数据不是用来“杀熟”的

- meta|三体限定联名,直降700元,能独立通话!华为WATCH3这价格值了

- 马斯克|4月,全力转向元宇宙的Meta仍在烧钱